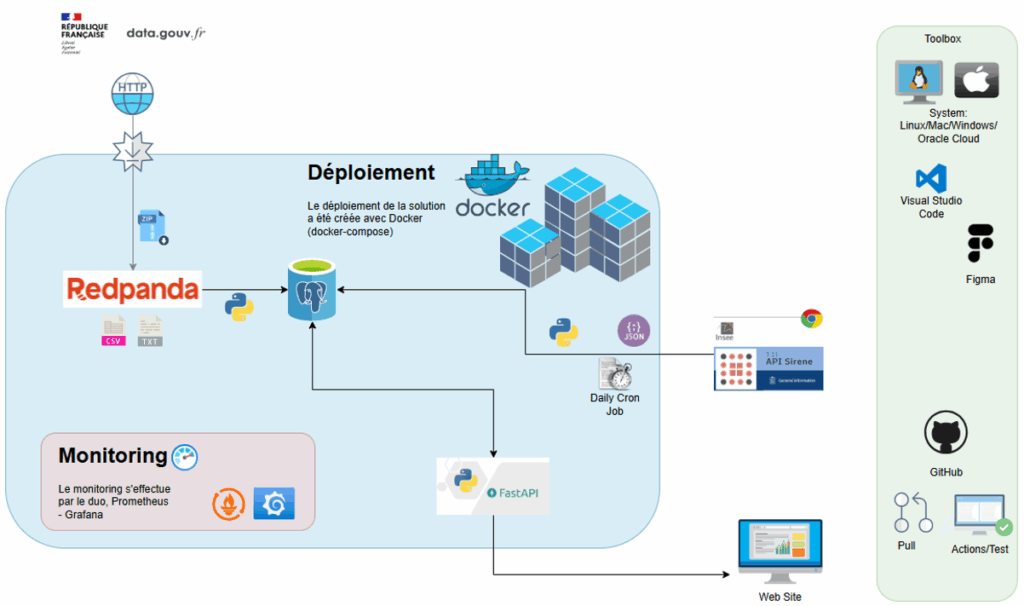

SIREN/SIRET – Une plateforme data pour explorer les entreprises françaises

Contexte

Dans le cadre de ma certification Data Ingénieur (Mines Paris x DataScientest), j’ai travaillé en équipe sur un projet de bout en bout visant à développer une solution robuste et évolutive d’analyse des entreprises françaises.

Objectif : permettre aux utilisateurs (entrepreneurs, investisseurs, commerciaux) d’explorer, surveiller et analyser les données SIREN/SIRET via une API performante et une interface web interactive (carte et recherche avancée).

Objectifs

- Concevoir une infrastructure technique optimisée pour gérer des millions d’enregistrements.

- Mettre en place un pipeline de collecte, ingestion et nettoyage des données.

- Développer une API rapide et scalable.

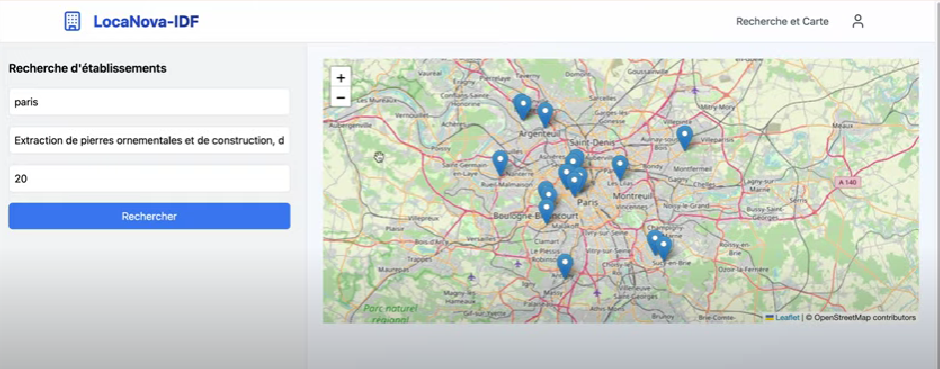

- Créer une interface web intuitive (carte interactive + recherche multi-critères).

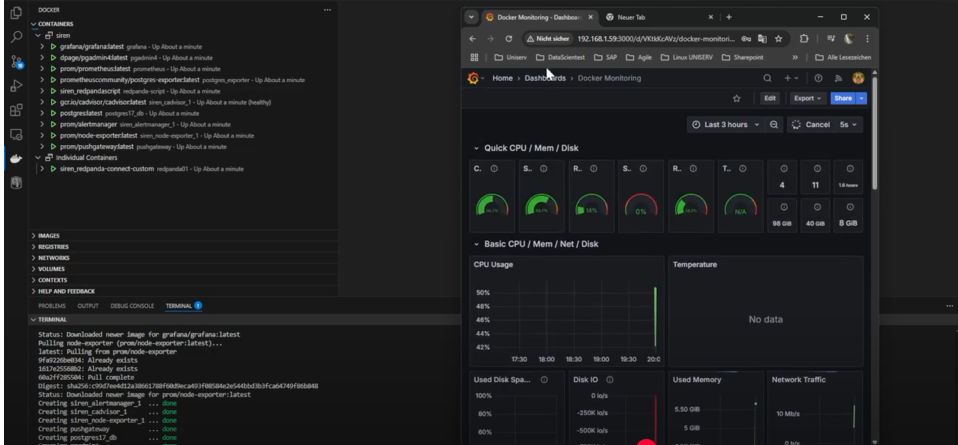

- Assurer monitoring et performance continue (Prometheus, Grafana).

Mon rôle & contributions

Au sein de l’équipe (3 personnes), j’ai apporté une expertise transversale :

- Conception web & UX : maquettes Figma, interface React/JS pour la carte interactive.

- API & intégration : mise en place de FastAPI pour la consommation des données.

- Modélisation et gestion des données : structuration des bases (PostgreSQL, indexation).

- Coordination et documentation : présentation finale, storytelling projet, suivi de la cohérence technique.

Technologies utilisées

- Base de données : PostgreSQL, PostGIS (indexation, volumétrie >3M enregistrements).

- Conteneurisation & déploiement : Docker, Docker Compose.

- Streaming & pipeline : Redpanda (alternative Kafka).

- API : FastAPI, Python.

- Frontend : React, Figma.

- Monitoring : Prometheus, Grafana.

Résultats

- +3 millions d’entreprises indexées (données Île-de-France).

- Temps de réponse <500 ms sur les requêtes.

- Pipeline automatisé de mise à jour quotidienne via API SIRENE.

- Interface fluide avec carte interactive et recherche avancée.

- Evolution à prévoir: échelle nationale (objectif 40M d’enregistrements).

Apprentissages clés

- Travailler sur la scalabilité et performance d’une architecture data réelle.

- Gérer les contraintes API et volumétrie.

- Confronter la modélisation théorique aux enjeux pratiques (index, normalisation vs performance).

- Collaborer en équipe pluridisciplinaire (backend, data, web).

Architecture projet SIREN/SIRET

Monitoring

Interface Sign in/Sign up

Carte interactive / Interface utilisateur